Differences

This shows you the differences between two versions of the page.

| Both sides previous revisionPrevious revision | Next revisionBoth sides next revision | ||

| jobs [2024/02/16 09:22] – [Theses and Student Jobs] kording | jobs [2024/05/02 10:51] – [Theses and Student Jobs] kording | ||

|---|---|---|---|

| Line 119: | Line 119: | ||

| - | == Übersetzung einer globalen Produktklassifikation in eine bestehende Ontologie | + | == Integration von common-sense anhand eines alltäglichen Beispiels |

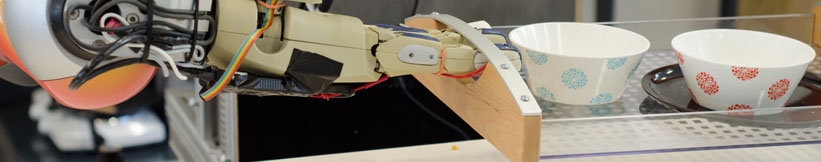

| - | In dieser Arbeit soll die GS1 Produktklassifikation | + | In dieser Arbeit soll anhand eines alltäglichen Beispiels (einem Roboter, der verschiedene Schneideaktionen ausführen können soll), common-sense Wissen |

| Die Aufgaben dazu sind: | Die Aufgaben dazu sind: | ||

| - | * Einarbeitung in Web Scraping und Abfrage der Daten von GS1 | + | * Einarbeitung in Wissensrepräsentation |

| - | * Einarbeitung in Owlready und Erstellen der Taxonomie | + | * Einarbeitung in Owlready und entitity linking |

| - | * Erstellung des Jupyter Notebooks mit einem Beispiel, wie andere Ontologien verbunden werden können (die Beispielontologie wird gestellt) | + | * Erstellung von Kompetenzfragen und Evaluierung der Integration |

| - | + | ||

| - | + | ||

| - | Contact: [[team: | + | |

| - | + | ||

| - | + | ||

| - | == Nutzung von chatGPT zur Erstellung von spezifischen Wissensbasen (BA Thesis) == | + | |

| - | + | ||

| - | In dieser Arbeit soll chatGPT (oder ähnliche Tools) genutzt werden, um maschinenlesbares Wissen für eine neue Aufgabe zu erstellen. Dabei sollen z.B. Umgebungsmerkmale und semantische Relationen abgefragt werden können. Die Arbeit soll geeignete prompts zur Erstellung solcher Wissensbasen erarbeiten. Die Informationen sollen anschließend per script extrahiert werden, so dass Agenten sie nutzen können. | + | |

| - | + | ||

| - | Die Aufgaben dazu sind: | + | |

| - | * Einarbeitung in Prompting mit chatGPT o.ä. | + | |

| - | * Einarbeitung in Web Scraping und NLP parsing | + | |

| - | * Einarbeitung in Owlready und basic entitity linking | + | |

| - | * Erstellung | + | |

| - | * Erstellung eines Jupyter Notebooks mit einem Beispiel | + | |

Prof. Dr. hc. Michael Beetz PhD

Head of Institute

Contact via

Andrea Cowley

assistant to Prof. Beetz

ai-office@cs.uni-bremen.de

Discover our VRB for innovative and interactive research

Memberships and associations: